苹果人像相机模式到底是如何工作

作者:本站整理 时间:2016-10-26

人像相机模式的景深效果其实是 iPhone 7 Plus 两个摄像头的副产品。它使用的是苹果收购的 LiNx 公司的技术,通过双摄像头、摄像头阵列实时测量画面的景深数据,并利用算法将照片上的各物体合并在一起,这样就可以创建 3D 照片。这其中并没有使用到苹果公司在 2013 年收购的 3D 移动传感器公司 Primesense 的技术,但是相比这家公司的技术应该很快也会被利用到 iPhone 上。

iPhone 双摄像头技术以及它的“Fusion”能够给用户带来很多好处。Fusion 就是苹果将广角镜头和长焦镜头的图像融合到一起,以获得最好图像效果的一种方法。这些好处就包括随着 iOS 10.1 测试版一起到来的人像相机模式。

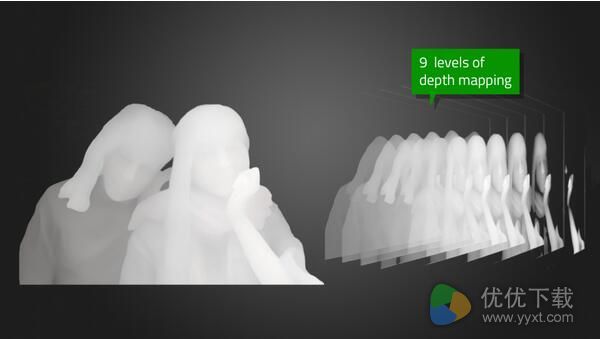

iPhone 7 Plus 升级 iOS 10.1 之后,用户打开相机应用之后会在“照片”和“正文形”之间看到“人像”。苹果对此描述为:创建带景深效果的人像照片,使主体部分更锐利,同时创建美观的模糊背景。在人像相机模式之下,iPhone 7 Plus 身上的 56mm 镜头将主要用来捕捉主画面,而 28mm 镜头则是用来收集景深数据以生成 9 层图像。

这是苹果的相机系统的工作方式,广角镜头和长焦镜头“看”图像的角度稍微不同,图像被分割成 9 层与相机有着不同距离的图像。一旦生成这 9 层被分割的图像之后,它就可以确定哪几层图像已经清晰锐利地显示出来,而哪几层图像上应该使用模糊效果。根据苹果的介绍,这种模糊效果并不是高斯模糊,而是一种轮廓比较明显的、呈圆形的模糊效果。预览模糊效果来自苹果的 Core Image API。

长焦镜头检测到拍摄对象之后会自动进行对焦,iPhone 中的图像处理器就会对背景中的物体使用模糊效果,与拍摄主体距离越远,模糊效果越严重。

比如摄像头分析场景之后将拍摄主体确定在 8 英尺之外的地方,它就会开始分割图像,逐渐对不同层级的图像采用不同程度模糊效果。靠近拍摄主体的物体显示效果会比距离较远的物体清晰,距离最远的其模糊度也达到了最大等级。

近景模糊和远景模糊效果不同。你可以将拍摄主体放到拍摄场景的“正中间”,它还是能够识别并将其独立出来。

关于距离应该多远,这方面并没有一个明确的范围,因为它们是基于拍摄者和拍摄主体的距离曲线、主体占据了多少框架以及所谓的“深”到底有多深来确定的。

根据测试,一般物体或者场景在 6 英寸(约合 15.24厘米)或者更远的距离时,拍摄出来可获得最大模糊效果。在这个距离之内,模糊效果比较少。这些都是无缝的,你可以在屏幕上看到实时预览效果,这时它的帧速率将低于 30FPS,或许是 24FPS,但足以给你提供精准的预览。拍摄时没有所谓的 600-650 毫秒延迟。

为了锁定人像主体,并尽可能将其与背景分离开来,苹果利用人脸识别以快速找到主体,让图像信号处理器知道哪些东西应该清晰显示出来,哪些不需要。

屏幕上会显示实时指导信息,让用户知道光线是否充足、与拍摄物体的具体是否合适等,人像相机拍摄要求必须有充足的光线,光线不足或者对比度太低情况下这个模式都无法工作。另外长焦镜头的最短对焦距离为 19 英寸(约合 48.26 厘米)。

用户在该模式拍摄的时候将得到两张照片,一张是有背景虚化效果的,照片上有黄字“景深效果”提示,一张是正常拍摄效果的照片。当然用户也可以通过设置选择拍摄时仅保留背景虚化的照片。